Für viele Großunternehmen bilden das Mainframe und die z/OS-Plattform seit Jahrzehnten das Rückgrat für geschäftskritische Anwendungen. Enorme Datenmengen befinden sich weiterhin in Db2, VSAM oder IMS – das Ergebnis jahrzehntelanger kontinuierlicher Nutzung. Die zugehörigen Anwendungen sind häufig in Cobol geschrieben, jedoch nimmt das interne Fachwissen zur Wartung dieser Technologie zunehmend ab. Der Druck wächst daher stetig, sich vom Mainframe zu lösen und die interne IT-Landschaft zu modernisieren.

Doch dieser Wandel bringt erhebliche Herausforderungen mit sich:

- Wie lassen sich Altdaten zuverlässig auf neue Systeme migrieren?

- Wie geht man mit den Besonderheiten und der Komplexität unterschiedlicher Datenquellen um?

- Wie können neue Anwendungen mit aktuellen, produktionsnahen Daten effektiv getestet werden?

- Wie wird sichergestellt, dass Datenschutzvorgaben während des gesamten Prozesses eingehalten werden?

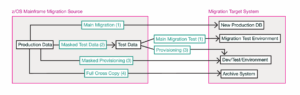

Datenbewegungen während der Migration

Beim Übergang vom Mainframe zu modernen Plattformen sind mehrere Datenbewegungspfade notwendig – sowohl zur Unterstützung des eigentlichen Migrationsprozesses, als auch zur Versorgung von Entwicklungs- und Testteams. Während sich der zentrale Migrationspfad auf die Überführung geschäftskritischer Daten in die neue Anwendungsumgebung fokussiert, erfordern umfangreiche Transformationsprojekte darüber hinaus separate Datenflüsse – für sichere Tests, flexible Bereitstellung und langfristige Archivierung.

Der Haupt-Migrationspfad

Der zentrale Datenstrom umfasst die einmalige oder schrittweise Migration von Produktionsdaten aus dem z/OS-Quellsystem in die Zielplattform. Dieser Pfad bildet die Grundlage für das neue System, indem er dessen operative Datenbank mit aktuellen, validierten Informationen initialisiert. Ein einfacher Datenabzug per „Cross Copy“ ist technisch oft möglich – jedoch setzen viele Unternehmen bei umfangreichen Restrukturierungen oder Transformationen auf eigens entwickelte Tools oder individuelle Migrationslösungen (1).

In der Praxis erfolgt die Migration häufig in Phasen: Zunächst wird eine Datenreplikation auf die neue Plattform vorgenommen, gefolgt von einer schrittweisen Umstellung der Strukturen – zur Minimierung von Risiken und Komplexität.

Bereitstellung maskierter Testdaten

Zur Absicherung des Migrationsprozesses ist ein separater Datenfluss erforderlich, der anonymisierte oder maskierte Testdaten (2) direkt aus dem Quellsystem bereitstellt. So können Teams Migrationsroutinen entwickeln, testen und optimieren, ohne produktive, sensible Daten offenzulegen. Solche Datensätze sind essenziell für schrittweises Testen und für die Einhaltung von Datenschutzauflagen in der Entwicklungsphase.

Cross Copy für Test- und Entwicklungsumgebungen

Über die initiale Migration hinaus benötigen Projekte flexible Möglichkeiten, Teilmengen von Daten – sowohl aus Produktiv- als auch Testsystemen unter z/OS – in die Zielumgebung zu kopieren (3). Diese Cross-Copy-Prozesse versorgen Entwicklungs- und Testteams mit aktuellen, produktionsähnlichen Datenbeständen und ermöglichen realitätsnahe Tests und iteratives Feintuning – ohne die Hauptmigration zu beeinträchtigen.

Umfassender Archivierungspfad

Häufig ist zudem ein vollständiger Systemabzug zur Archivierung erforderlich. Dabei wird eine 1:1-Kopie der Legacy-Umgebung erstellt – z. B. durch Laden des gesamten Datenbestands in eine moderne Datenbank wie PostgreSQL (4). Solch ein Archiv dient primär der Nachvollziehbarkeit, Auditierbarkeit und eventuellen Korrekturen nach der Migration – nicht dem Weiterbetrieb alter Anwendungen. So bleibt der Zugriff auf historische Daten per Abfrage möglich, auch nach Umstrukturierungen der produktiven Umgebung.

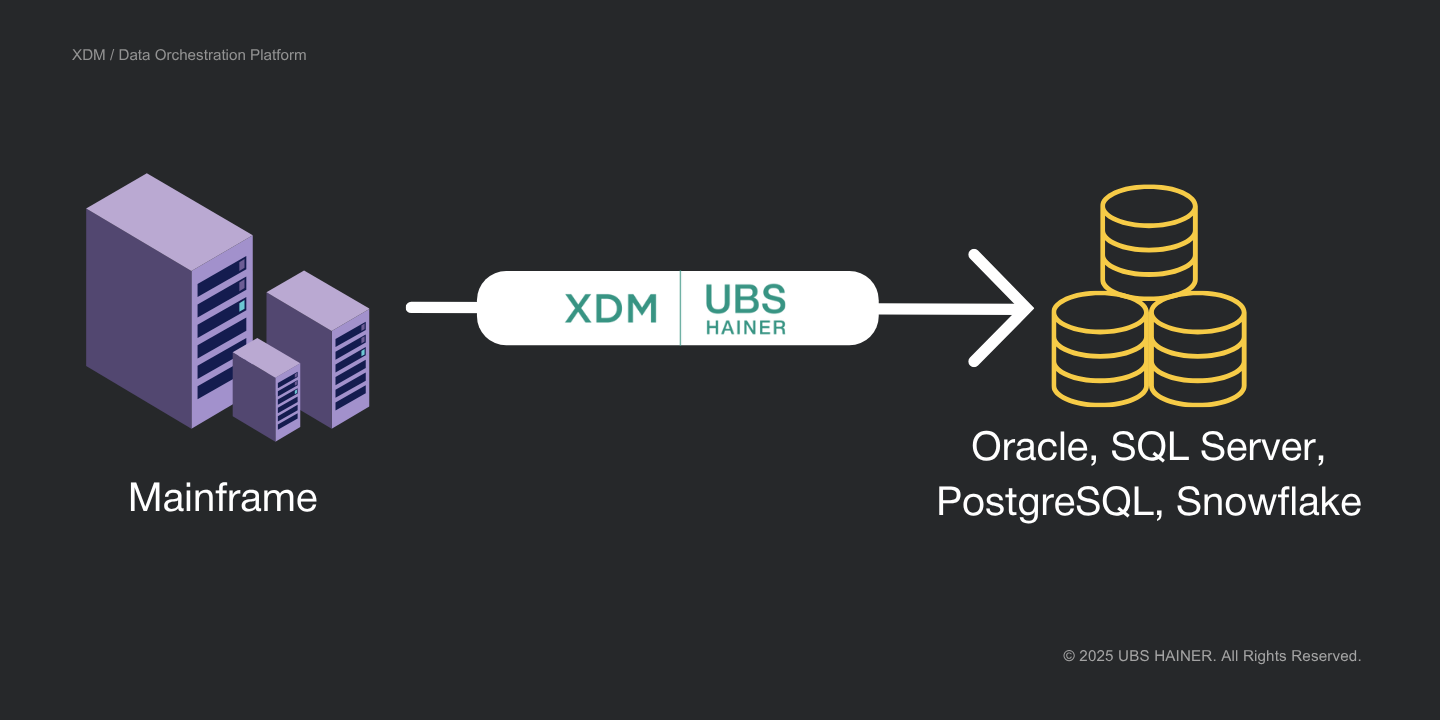

XDM als Lösung für Datenmigration und Testdatenmanagement

XDM bietet konkrete Lösungen, um Migrationen und die laufende Bereitstellung von Testdaten signifikant zu vereinfachen:

- Plattformübergreifende Datenextraktion und -beladung

XDM unterstützt native Mainframe-Quellen wie Db2 z/OS, VSAM und IMS sowie moderne Zielplattformen wie Oracle, SQL Server, PostgreSQL, Snowflake u. v. m. Daten werden systemübergreifend migriert, inklusive automatischer Konvertierung von Formaten und Datentypen – was manuelle Aufwände und Projektrisiken minimiert. - Automatisierter Umgang mit Strukturunterschieden

Legacy- und Zielsysteme unterscheiden sich oft strukturell: neue oder fehlende Felder, umbenannte Tabellen, geänderte Datentypen. XDM erkennt solche Unterschiede automatisch, erzeugt bei Bedarf Ziel-DDLs und wendet Mapping-Regeln zur Umbenennung oder Transformation an – selbst bei modernen Zielarchitekturen mit verteiltem Datenmodell. - Integrierte Datenmaskierung und Anonymisierung

Der Einsatz echter Produktionsdaten in Testumgebungen ist insbesondere in regulierten Branchen wie Versicherungen, Gesundheitswesen und Banken nicht zulässig. XDM enthält eine Vielzahl vorkonfigurierter Maskierungsalgorithmen (für Namen, Adressen, Kontonummern etc.), die flexibel angewendet werden können – datenschutzkonform. Alternativ kann XDM synthetische, aber realitätsnahe Testdaten per KI generieren. - Workflow-Automatisierung & Self-Service-Testdatenbereitstellung

XDM ermöglicht die Modellierung und Automatisierung durchgängiger Bereitstellungsprozesse – von der Datenauswahl und Maskierung bis zur Lieferung und Validierung im Zielsystem. Über eine benutzerfreundliche Weboberfläche können Fachbereiche oder Tester selbstständig frische Testdaten anfordern – ohne Mainframe-Know-how. - Monitoring und Nachvollziehbarkeit

Jeder Schritt – ob Migration oder Testdatenbereitstellung – wird umfassend protokolliert und ausgewertet. Anomalien oder Probleme werden frühzeitig sichtbar. Lückenlose Audit-Trails zeigen, welche Daten wann und wie übertragen wurden – inklusive angewandter Transformationen.

Fazit

Die Migration von z/OS zu modernen Plattformen ist eine anspruchsvolle Aufgabe. Doch intelligente Werkzeuge wie XDM vereinfachen zwei der größten Herausforderungen: die zuverlässige Datenmigration und die konsistente, datenschutzkonforme Bereitstellung von Testdaten. Damit wird es möglich, neue Anwendungen robust zu testen, regulatorische Anforderungen zu erfüllen – und gleichzeitig die Innovationskraft der IT nachhaltig zu stärken.